Các mô hình ngôn ngữ lớn (LLM) không chỉ đơn thuần là chatbot hay những công cụ tìm kiếm tiên tiến hơn nhưng đôi khi còn bị “ảo giác”. Thực tế, có vô vàn ứng dụng LLM tự host trong bối cảnh năng suất, giúp ích đáng kể trong cuộc sống hàng ngày. Thay vì chỉ trò chuyện, khi được xem như một mô hình ngôn ngữ thực thụ, các LLM có thể tối ưu hóa nhiều khía cạnh từ công việc đến quản lý cuộc sống cá nhân. Dưới đây là những cách mà một mô hình LLM cục bộ đã được tôi triển khai để nâng cao hiệu quả và sự tiện lợi.

5. Biến Obsidian thành ứng dụng ghi chú siêu việt

Tận dụng LLM cục bộ với ghi chú của bạn

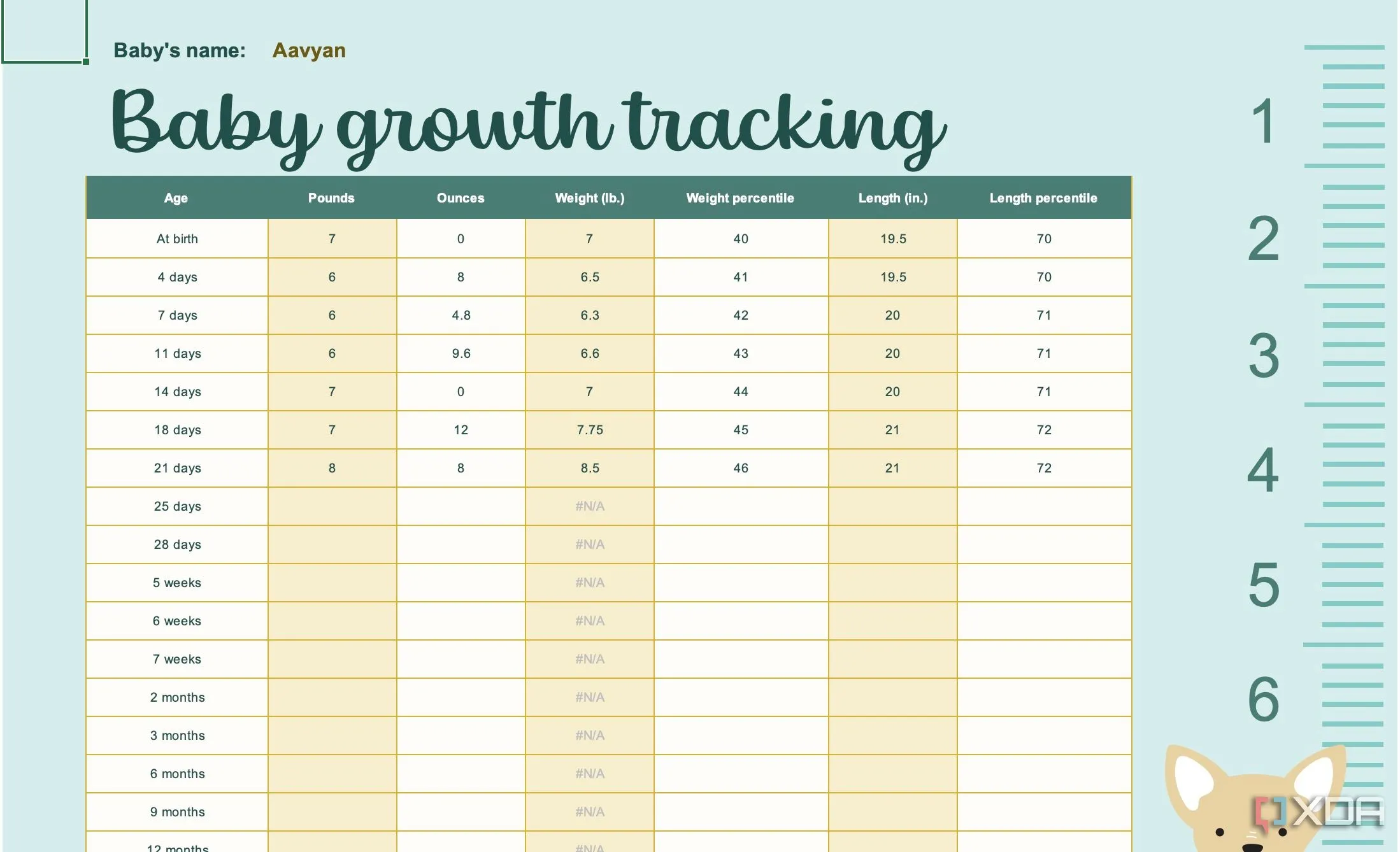

Tôi đã sử dụng Obsidian một thời gian khá lâu, và nó ngày càng trở thành trung tâm cuộc sống số của tôi. Không chỉ tất cả các ghi chú liên quan đến công việc, mà cả các dự án cá nhân, thử nghiệm home lab, và dự án kỹ thuật đảo ngược đều được lưu trữ bên trong nó.

Với sự hỗ trợ của một plugin xuất sắc có tên “LLM Workspace“, bạn có thể tích hợp Obsidian với mô hình LLM tự host của mình. Bạn cần định nghĩa một mô hình embedding và một mô hình chat, sau đó tạo một “không gian làm việc” (workspace) với các liên kết đến các ghi chú khác của bạn. Từ đó, bạn có thể lập chỉ mục tất cả các ghi chú đó và truy vấn chúng trực tiếp từ giao diện người dùng của Obsidian.

Giao diện Obsidian tích hợp LLM cục bộ hỗ trợ quản lý ghi chú hiệu quả

Giao diện Obsidian tích hợp LLM cục bộ hỗ trợ quản lý ghi chú hiệu quả

Lưu ý rằng đối với plugin này, phiên bản mới nhất trong kho plugin cộng đồng hiện không hỗ trợ Ollama. Tôi đã phải tải xuống plugin từ GitHub và cài đặt thủ công, nhưng nó hoạt động hoàn hảo ngay sau khi tôi thiết lập. Tôi có thể truy vấn các ghi chú của mình và nhận được ý tưởng về cách mở rộng hoặc sắp xếp chúng tốt hơn. Hơn nữa, không có bất kỳ lo ngại nào về quyền riêng tư dữ liệu, vì các ghi chú của tôi không bao giờ rời khỏi mạng gia đình. Điều này biến Obsidian thành một công cụ ghi chú mạnh mẽ và an toàn hơn bao giờ hết, thực sự là một trong những ứng dụng LLM tự host mang lại giá trị cao nhất.

4. LLM tự host – Trái tim của hệ thống Home Assistant

Tóm tắt ngày và dự báo thời tiết thông minh

Một LLM cục bộ là xương sống cho toàn bộ thiết lập Home Assistant của tôi hiện nay, cung cấp năng lượng cho rất nhiều tự động hóa. Từ việc tóm tắt công việc tôi cần hoàn thành trong ngày đến các thông báo thời tiết tùy chỉnh, nó đã trở nên vô giá. Ngay cả trợ lý giọng nói cục bộ của tôi (nghe giống GLaDOS, rất đáng thử), cũng sử dụng Gemma3 27B IT QAT để phản hồi nhanh chóng và chất lượng cao.

Đây là một trong những lợi ích tốt nhất của một LLM tự host, và nó thực sự tuyệt vời. Tôi có thể đặt các câu hỏi dựa trên ngữ cảnh về nhà thông minh của mình, và không có bất kỳ phản hồi “định sẵn” nào. Dù tôi hỏi liệu trời có mưa vào ngày mai, liệu tôi có cần kem chống nắng hôm nay, hay liệu trời có mưa sau 9 giờ tối không, tôi sẽ nhận được câu trả lời được cung cấp bởi dữ liệu thời tiết của tôi, và mỗi lần phản hồi đều là duy nhất.

Thông báo động từ Home Assistant với bản tóm tắt thời tiết nhờ LLM

Thông báo động từ Home Assistant với bản tóm tắt thời tiết nhờ LLM

Tất cả những điều này không chỉ giúp tôi tiết kiệm thời gian mà còn giúp tôi nắm bắt nhanh chóng thông tin trong ngày. Tôi nhận được tóm tắt các cuộc gọi, khối lượng công việc, và nếu tôi cần đến bất kỳ đâu, kèm theo thời tiết trong ngày. Ngoài ra, hãy nhớ rằng tôi đang sử dụng một mô hình khá mạnh cho trường hợp sử dụng này. Ngay cả một mô hình 1B nhỏ như Tinyllama hoặc một mô hình 7B cũng sẽ làm được việc; tôi chỉ sử dụng Gemma3 cho gần như mọi thứ khác, vì vậy tôi cũng có thể sử dụng nó ở đây. Đây là ví dụ điển hình về khả năng tự động hóa nhà thông minh với AI cá nhân.

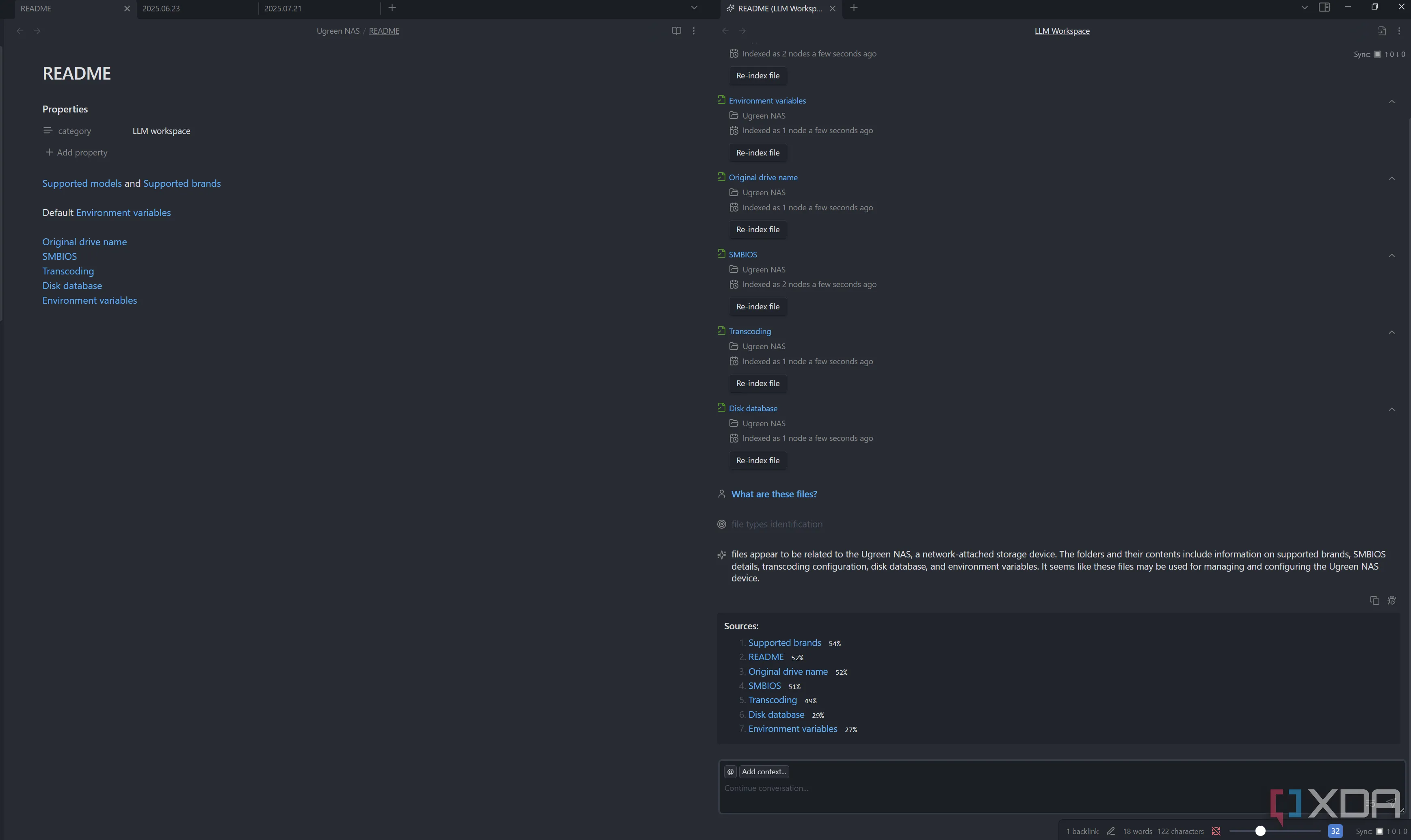

3. Continue.dev – Tiện ích mở rộng không thể thiếu cho VS Code

Tổng quan toàn diện cho quy trình lập trình

Chúng ta đều đã nghe nói về hiện tượng “lập trình theo cảm hứng”, nhưng sự thật là một LLM vẫn là một công cụ tuyệt vời để sử dụng trong quy trình làm việc lập trình của bạn. Đến mức các công cụ như OpenAI’s Codex, Gemini CLI và Claude Code đang tạo nên làn sóng trong không gian lập trình nhờ khả năng của chúng.

Nói rõ hơn, tôi sẽ không bao giờ dựa vào một LLM để làm lập trình thay cho tôi, nhưng nó có thể tuyệt vời để hỏi xem có bất kỳ vấn đề nào với mã của bạn mà nó có thể phát hiện ngay lập tức, hoặc thậm chí sử dụng nó để bắt đầu cách tiếp cận một vấn đề. Rõ ràng bạn nên thực hiện một bài kiểm tra nhanh và đặt câu hỏi liệu phản hồi có ý nghĩa trong ngữ cảnh mã của bạn hay không, nhưng đó có thể là một cách tuyệt vời để bạn suy nghĩ về mã của mình theo những cách khác và những rủi ro tiềm ẩn mà nó có thể gây ra. Continue.dev hoạt động với các mô hình từ xa hoặc mô hình cục bộ, và tôi trỏ nó đến phiên bản Ollama của mình với Qwen-2.5:32B-Instruct.

Màn hình VS Code hiển thị tiện ích Continue.dev hỗ trợ lập trình với AI

Màn hình VS Code hiển thị tiện ích Continue.dev hỗ trợ lập trình với AI

Ví dụ, tôi đã phát triển phần mềm riêng để quản lý màn hình LED ma trận HUB75 64×32 Waveshare từ ESP32 và Raspberry Pi. Tôi có thể đơn giản hỏi, ngay trong VS Code, liệu có bất kỳ vấn đề nào với mã của mình. Sau đó, nó sẽ phân tích và chỉ cho tôi những nơi có vấn đề tiềm ẩn, đồng thời đưa ra các giải pháp cho chúng. Điều này thật tuyệt vời, và có thể đặc biệt hữu ích nếu tôi có một ngày làm việc kém hiệu quả khi lập trình hoặc tôi không quen thuộc với ngôn ngữ mà tôi đang viết mã. Nó có thể không phát hiện ra mọi thứ, hoặc các đề xuất của nó có thể không đúng 100% mọi lúc, nhưng mọi lỗi hoặc vấn đề cấp phát bộ nhớ mà nó phát hiện chính xác đều có nghĩa là một cải tiến tức thì cho mã của tôi.

2. Nâng tầm cấu trúc Home Lab của bạn

Giúp bạn khám phá những điều chưa biết

Đôi khi, khi triển khai một phần mềm hoặc phần cứng mới, tôi cần một kế hoạch để cấu trúc cách thức triển khai nó. Tôi khá thành thạo về công nghệ và tự host, nhưng bản chất của việc không biết một điều gì đó thường là bạn không biết những gì bạn không biết.

Kết quả là, thật tốt khi truy cập vào LLM tự host của tôi, nơi có chi tiết về home lab của tôi trong một cơ sở tri thức trong Open Web UI, và hỏi cách một triển khai sẽ hoạt động trong ngữ cảnh phần cứng và phần mềm mà tôi đã sử dụng. Tôi không coi câu trả lời là câu trả lời đúng 100%, nhưng khi bạn không biết những gì bạn không biết, một thuật ngữ mới được đưa ra hoặc một kiến trúc tự host mà bạn không quen thuộc có thể thúc đẩy một loạt nghiên cứu về một chủ đề mới mà bạn chưa biết.

Khi nói đến LLM, “tin tưởng nhưng phải kiểm chứng” (trust but verify) là một cách tiếp cận tuyệt vời, ngay cả khi “tin tưởng” là một từ hơi mạnh. Nó sẽ thường đưa bạn đi đúng hướng, nhưng chúng thường sẽ bỏ sót các chi tiết quan trọng. Hãy sử dụng nó như một công cụ tìm kiếm ngữ nghĩa; mô tả những gì bạn đang làm và sử dụng kết quả để tự nghiên cứu về một chủ đề mà bạn có thể không quen thuộc. LLM nên là một công cụ giúp bạn suy nghĩ chứ không phải là sự thay thế cho việc suy nghĩ hoàn toàn.

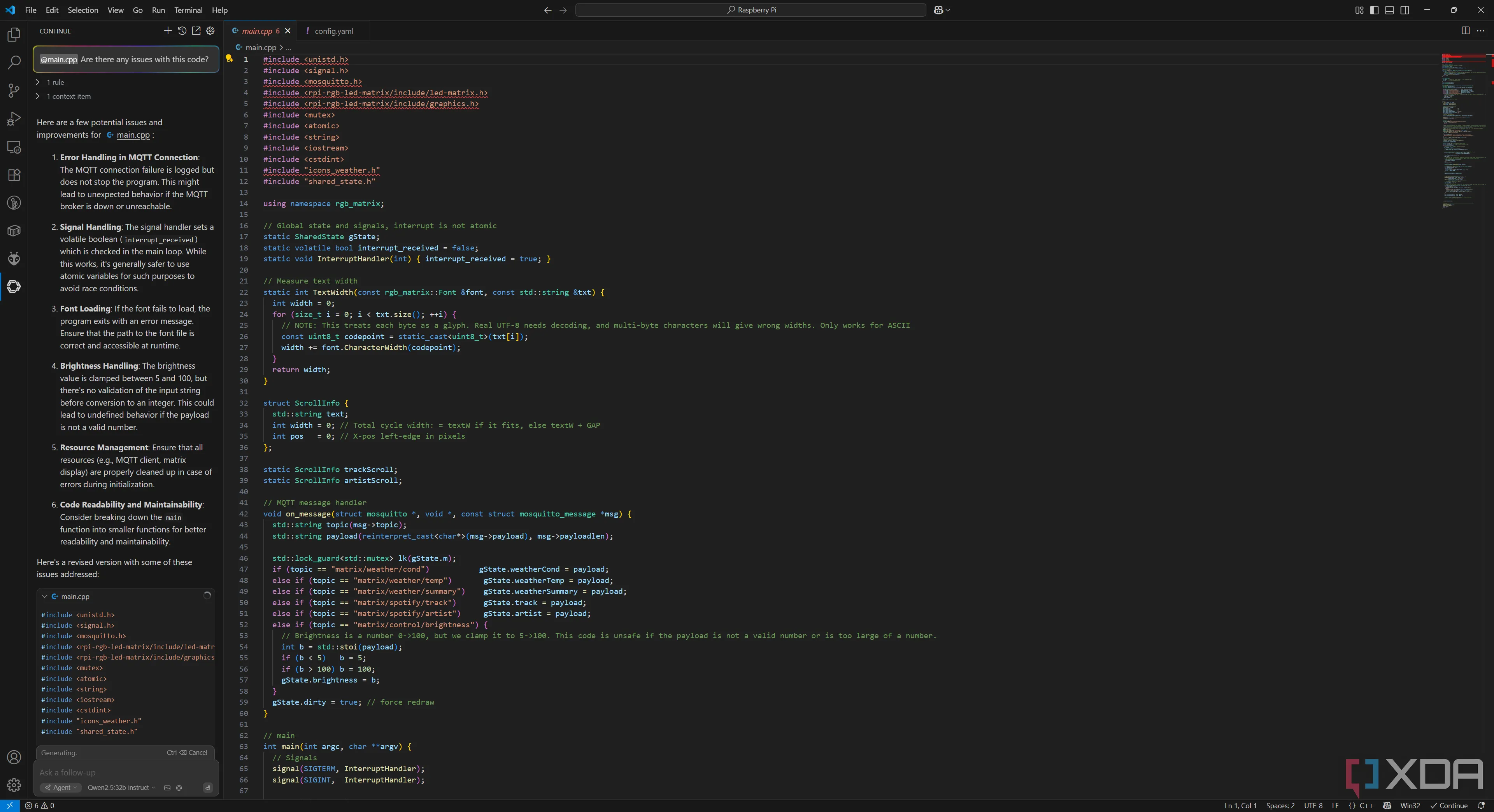

1. Tối ưu quy trình phân loại email

Tức thì có bản tóm tắt các email “quan trọng”

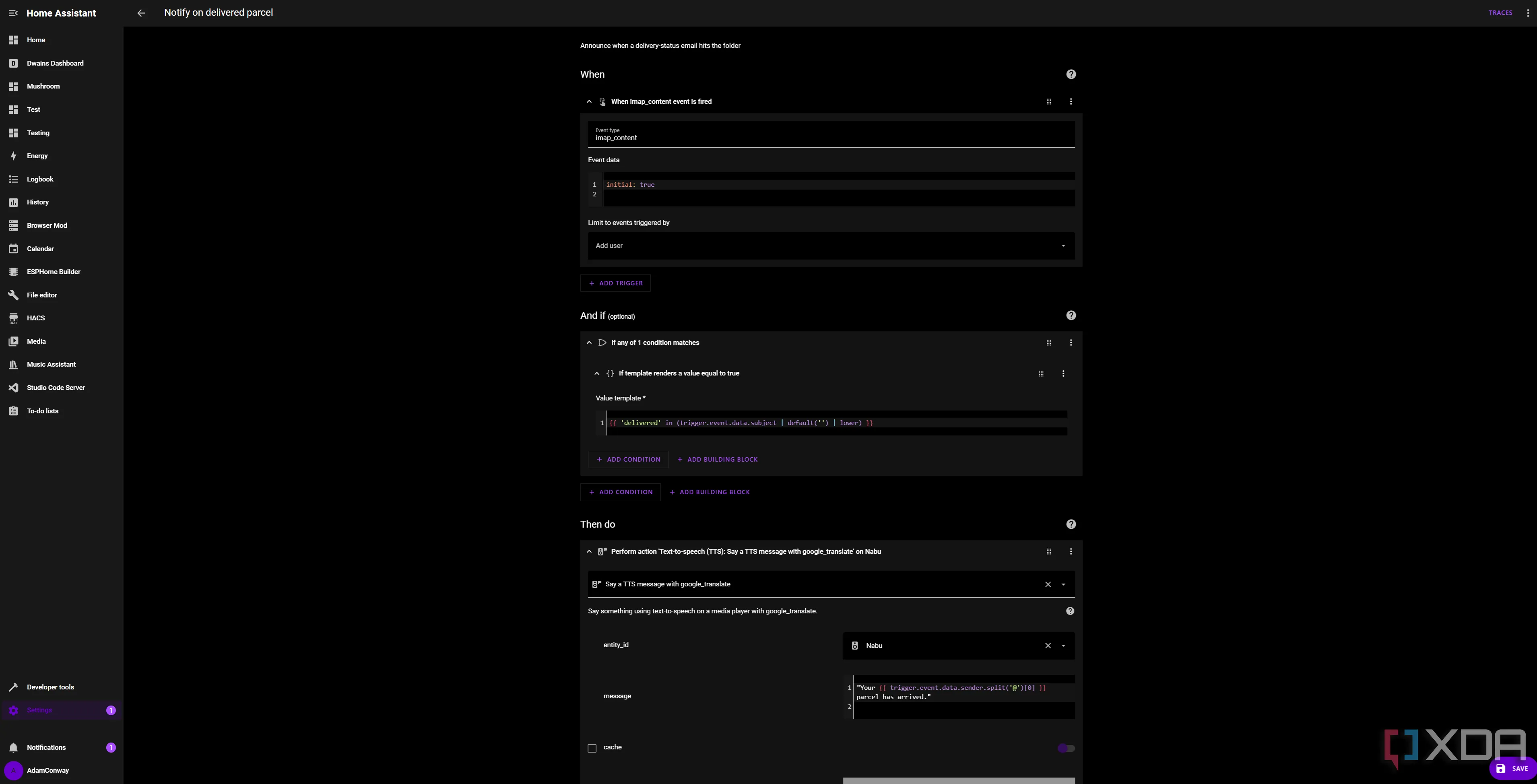

Đây là điều mà tôi đang thử nghiệm hiện tại, nhưng bằng cách sử dụng Home Assistant và Ollama, tôi đang cố gắng xây dựng một hệ thống phân loại để gắn cờ liệu một email có nên được coi là “quan trọng” hay không, sử dụng tích hợp IMAP trong Home Assistant.

Thí nghiệm này cuối cùng có thể thất bại, nhưng ý tưởng khá đơn giản. Trích xuất nội dung email bằng Home Assistant, chuyển nó đến LLM cục bộ của tôi, và nhận phản hồi dựa trên việc nó có đáp ứng các tiêu chí được định nghĩa trước của tôi hay không. Nếu có, nó sẽ hiển thị trên bảng điều khiển của tôi (sử dụng một conditional card) để tôi không bỏ lỡ. Tôi thậm chí có thể tóm tắt bộ sưu tập các email đã tích lũy cho đến nay.

Tự động hóa Home Assistant thông báo gói hàng đến dựa trên email nhờ LLM

Tự động hóa Home Assistant thông báo gói hàng đến dựa trên email nhờ LLM

Một LLM cục bộ là hoàn hảo cho việc này; tôi không muốn chia sẻ email của mình với OpenAI, và một giải pháp tự host khắc phục vấn đề riêng tư tiềm ẩn này theo cách không ảnh hưởng đến hiệu suất. Một mô hình 27B là hơn cả đủ cho tác vụ này, và nhiều mô hình nhỏ hơn cũng có khả năng tương tự. Về lâu dài, nó sẽ giúp tôi tiết kiệm thời gian, nhưng tôi vẫn đang thử nghiệm nó vào lúc này.

LLM tự host mang lại sự khác biệt lớn

Chắc chắn, người ta có thể lập luận rằng ChatGPT và các LLM dựa trên đám mây khác rất tuyệt vời, nhưng sự thật là các mô hình cục bộ vẫn cực kỳ mạnh mẽ, và sức mạnh của các tùy chọn dựa trên đám mây đó, thành thật mà nói, là quá mức cần thiết. Tự host có nghĩa là tôi kiểm soát dữ liệu, ngữ cảnh và các tích hợp, và đó là điều quan trọng nhất đối với tôi. Các ứng dụng LLM tự host không chỉ mang lại hiệu suất đáng kinh ngạc mà còn đảm bảo quyền riêng tư và sự linh hoạt tối đa, biến chúng thành công cụ không thể thiếu cho bất kỳ ai muốn nâng tầm năng suất cá nhân và hệ thống công nghệ của mình.